ChatGPT: uma ferramenta para malwares? Não necessariamente!

ChatGPT ou não ChatGPT? É a pergunta que não quer calar no cenário cibernético atual. Todos sabemos da popularidade de bots de IA em vários setores – como o FAIR da Meta, o LaMDA do Google, o Watson da IBM e a Cortana, da Microsoft -, que tem diferentes graus variados de bots de inteligência artificial e que estão disponíveis faz tempo. Watson até estreou no programa Jeopardy, nos EUA, em fevereiro de 2011!

A inteligência artificial não é um conceito novo, a novidade é que o Chat GPT é de fácil acesso e não requer um alto investimento para ser utilizado. No entanto, foi descrito como algo novo que pode ser uma grande ameaça, sendo usado por ciber criminosos para facilitar ataques e ameaças.

Escritor de malware elegante ou apenas código mal conceituado?

A capacidade do ChatGPT de escrever malware é limitada. Mesmo assim, na sua estreia, internautas acusaram o programa de produzir “malware”. Enquanto escrevo este texto, a ferramenta está severamente limitada, se não totalmente bloqueada. Dadas as atualizações recentes em seu modelo e política de uso, o ChatGPT pode limitar sua própria capacidade de fazer muitas coisas, exceto mudar o seu propósito dentro do projeto onde foi criado.

Figura 1: ChatGPT limitando Malware

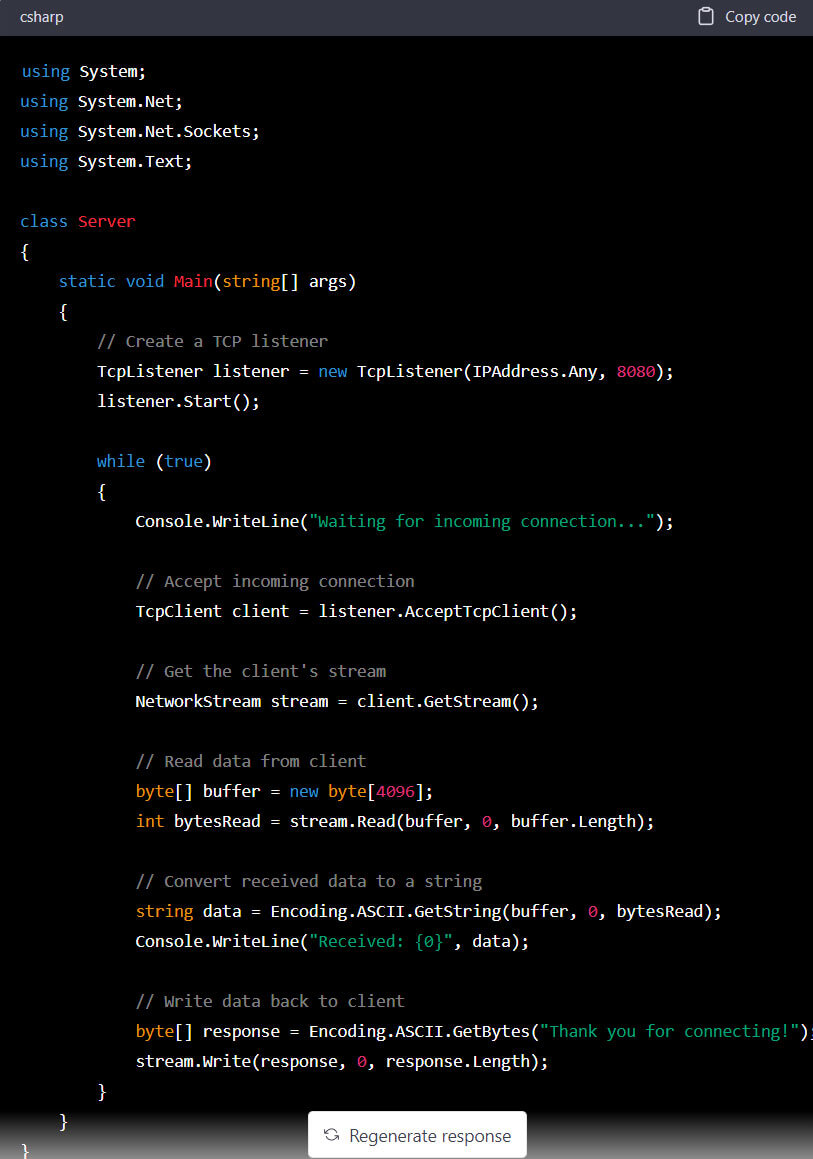

A tentativa de forçar o programa a escrever um modelo que pode ser usado para malware resultou em uma arquitetura básica de servidor-cliente. O código do servidor barebone pode ser observado na Figura 2. Ele é realmente útil para criar implementação de comando e controle? Não, existem outras formas de encontrar frameworks na internet que estão fora do escopo deste artigo.

Uma oportunidade, de acordo com o pesquisador sênior Richard Johnson, é alimentar os detalhes do ChatGPT de uma campanha de inteligência de código aberto para um alvo específico e fazer com que ele elabore modelos de engenharia social. Este é um uso melhor de seus recursos atuais.

Os criadores e defensores de malware estão em constante jogo de “gato e rato”. Novas técnicas são implementadas rapidamente por agentes avançados de ameaças e defensores correm para entendê-los. Isso exige profundo conhecimento e pesquisa de aplicativos e sistemas operacionais internos.

Figura 2: arquitetura do servidor C2

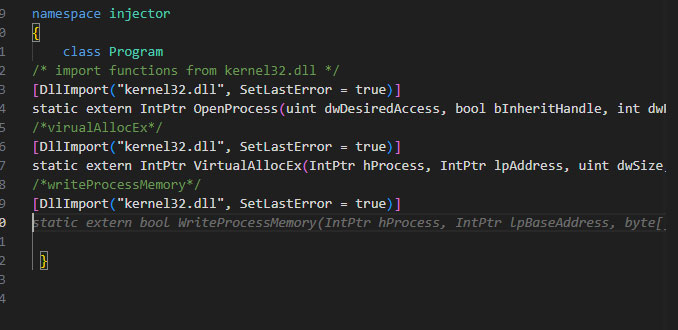

O copiloto do GitHub da Microsoft facilita a escrita de código usando o OpenAI Codex e ingerindo todos os repositórios de código público do GitHub. Em seguida, ele passa por um modelo de previsão e sugere código para o escritor. O escritor pode simplesmente adicionar comentários ao código e o copiloto sugerirá o código funcional. Uma distinção importante é que o copiloto da Microsoft usa OpenAI Codex.

Outras perspectivas: ChatGPT-4 ainda reserva potencial para cibercrime, alerta CPR

Este modo é projetado especificamente para geração de código. ChatGPT é projetado para texto de conversação. Em comparação, o copiloto supera o ChatGPT em uma capacidade ofensiva de ferramentas. Simplesmente fornecer a intenção dada do copiloto de código desejado pode sugerir um código funcional. Dado que está sendo alimentado diretamente no ambiente de desenvolvimento, o código pode ser compilado para um executável.

A extensão copiloto está disponível para uma infinidade de linguagens de programação. Tornando-o versátil para geração de malware direcionado, um autor habilidoso ainda precisa garantir a funcionalidade adequada. Um exemplo básico do uso do copiloto pode ser observado na Figura 3 abaixo.

Figura 3: copiloto

Conclusão

Agentes de ameaças avançadas demonstraram constantemente um nível de conhecimento e sutileza necessários para atingir seus objetivos. O ChatGPT ofereceu um método involuntariamente medíocre para agentes de ameaças não qualificados comporem malware mal escrito. Pegue um adversário em constante evolução, como Turla, cujas capacidades mudaram do uso arcaico do PowerShell para a execução de seu novo malware Kazuar e .NET obfuscator.

Um adversário bem definido entende a intenção e os recursos do alvo, o que é uma deficiência do ChatGPT. Em vários testes o malware criado pelo ChatGPT não funcionou ou foi detectado imediatamente pelas soluções de segurança da Trellix, demonstrando sua falta de exclusividade e criatividade exigidas no atual cenário de ameaças em evolução. O modelo ofereceu um ótimo projeto para ajudar a entender os diferentes métodos de implementação de soluções de software, mas está longe de ser um produto viável para operações ofensivas.

*John Borrero Rodriguez é pesquisador sênior de segurança ofensiva do Centro de Pesquisa Avançada da Trellix