Como funcionam os robôs que criam imagens

‘Primos’ do ChatGPT, Midjourney, DALL-E 2 e Stable usam inteligência artificial para ‘pensar’ como humanos e criar imagens com objetos e estilos artísticos escolhidos pelos usuários. Ferramenta gera debate sobre uso de propriedade intelectual e futuro do trabalho de ilustradores. Como funcionam os robôs que criam imagens novas em segundos

O robô ChatGPT ganhou fama por sua capacidade de “escrever” sobre quase tudo, desde redações e listas até tabelas e códigos de programação. A OpenAI, responsável pelo robô, tem outra invenção do tipo: o DALL-E 2 também usa inteligência artificial, mas para criar ilustrações.

O DALL-E 2 já tem ao menos dois fortes concorrentes: Midjourney e Stable Diffusion. As empresas responsáveis pelos dois últimos já foram processadas por três de artistas nos Estados Unidos que reclamaram de terem suas obras usadas sem autorização para treinar os robôs.

Entenda mais sobre os robôs “desenhistas” em 5 pontos:

O QUE SÃO: modelos de inteligência artificial treinados para “pensar” de forma parecida com o cérebro humano

COMO DESENHAM: usam uma técnica chamada “difusão”, que começa as imagens a partir de pontos aleatórios e, aos poucos, forma algo que pode ser reconhecido por um ser humano (veja mais abaixo)

COMO SÃO CRIADOS: os robôs usam conjuntos extensos com bilhões de fotos ligadas às suas descrições em texto para aprender a reconhecer objetos e estilos artísticos

QUAL O DEBATE: se esses robôs podem ou não substituir ilustradores profissionais e se o aprendizado a partir de imagens disponíveis na internet pode ser considerado roubo de propriedade intelectual

ONDE TESTAR: Midjourney, Stable Diffusion e DALL-E 2 estão abertos ao público em versões beta, que podem ser experimentadas em seus sites.

Quer se aprofundar? Veja perguntas e respostas a seguir.

Como os robôs funcionam?

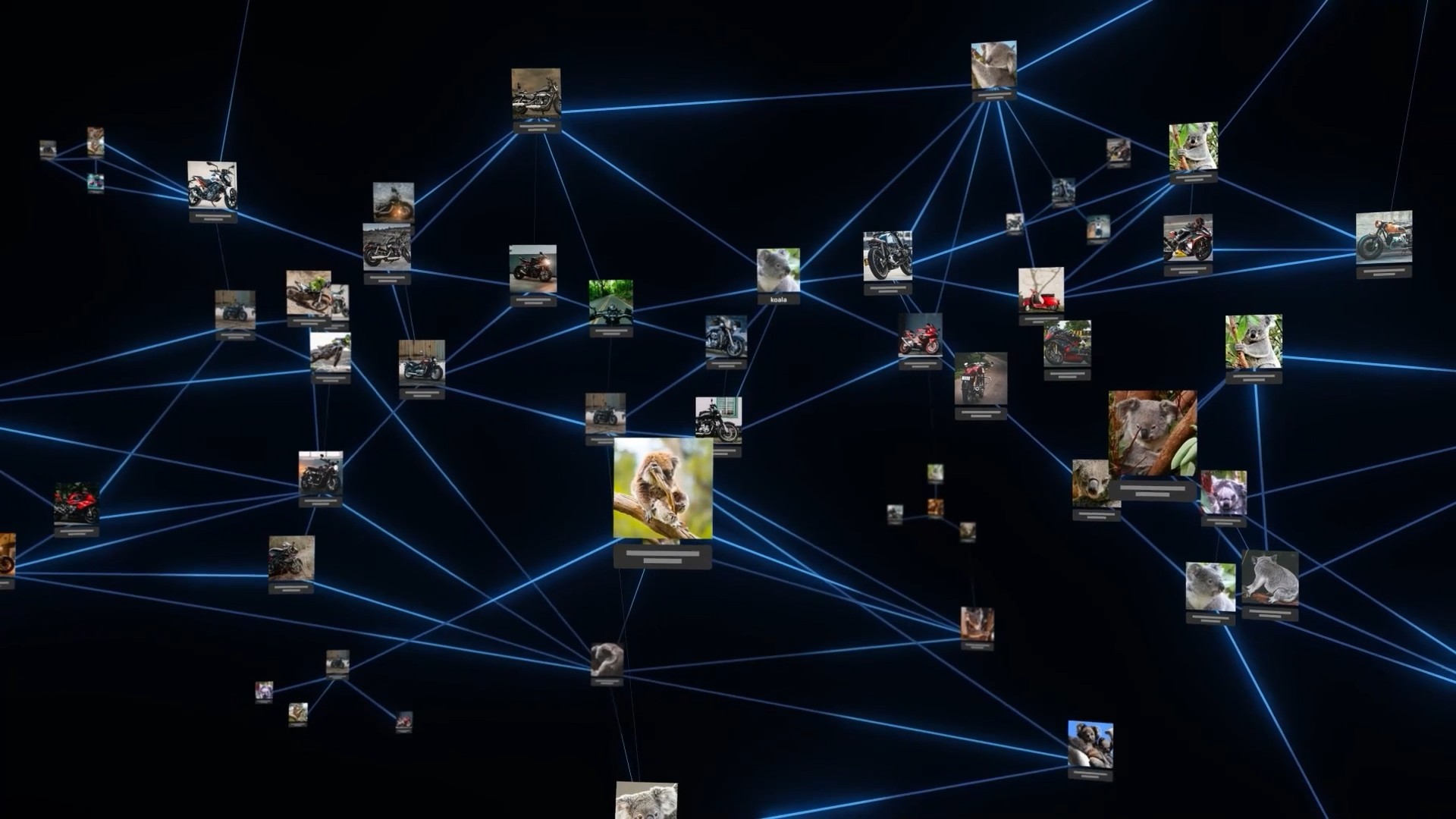

Os modelos são criados ao treinar redes neurais, método que ensina máquinas a “pensarem” e a fazerem ligações entre diferentes termos de uma forma parecida com a do cérebro humano.

Robôs que criam imagens a partir de descrição são treinados para pensar como o cérebro humano

Divulgação/DALL-E

Eles aprendem a identificar objetos a partir de um conjunto de dados com fotos e suas respectivas descrições. A ideia é fazer os robôs conseguirem relacionar itens que, em um primeiro momento, não tenham ligação entre si, como um “coala andando de moto”, exemplo usado pela OpenAI.

Depois de receberem uma instrução, os robôs fazem um processo chamado de “difusão”, em que começam com um padrão de pontos aleatórios. Esse padrão é alterado aos poucos até chegar em uma imagem que pode ser reconhecida.

DALL-E 2 é um dos que usam processo de “difusão” para criar imagens

Divulgação/DALL-E

O que podem fazer?

Os três robôs podem criar imagens novas que combinam objetos, ações e estilos propostos pelos usuários. O DALL-E 2 também pode adicionar ou remover itens de ilustrações, criar variações de fotos enviadas por usuários e aumentar imagens para além do que aparece no arquivo.

É o que fez o diretor de arte Vitor Dornelles em seus primeiros testes da ferramenta. Nas redes sociais, ele mostrou como as ferramentas imaginam que seria o restante do cenário de capas de discos de Cartola e Secos & Molhados.

Ele também mostrou pediu para os robôs imaginarem como seriam “Os Muppets” no estilo de pintura da artista Tarsila do Amaral ou a cidade do Rio de Janeiro como se estivesse em filmes com personagens feitos de massinha.

Criação do DALL-E 2 após receber descrição em inglês de “Os Muppets, pintados por Tarsila do Amaral”

Arquivo/Vitor Dornelles

Criação do DALL-E 2 para a descrição “Vista da cidade do Rio de Janeiro a partir do Pão de Açúcar no formato Claymation [técnica de animação com massinha]”

Arquivo/Vitor Dornelles

Imagens feitas com o robô Midjourney no estilo de Van Gogh

Reprodução/Midjourney

Dornelles disse ter ficado impressionado com as imagens, ainda que em alguns casos a proposta tenha dado errado. “É um pouco como rolar dados, porque você nunca sabe qual vai ser o resultado”.

Segundo ele, os robôs entendem as descrições de imagens (também chamadas de prompts) de sua própria forma. Por isso, é preciso se adaptar à linguagem de cada um deles antes de pedir algo.

“Depois de escrever muitos prompts, você acaba aprendendo algumas coisas”, disse. “Tem até uns manuais informais que algumas pessoas na internet compilaram tentando reunir o conhecimento adquirido por todos os usuários até aqui”.

De onde vêm as imagens?

A OpenAI e a Midjourney não revelam a origem do conjunto de dados usado para treinar os seus modelos. Mas a Stable Diffusion diz que o robô foi treinado com um conjunto chamado LAION 5b, que reúne mais de 2,3 bilhões de imagens com suas respectivas descrições em texto.

Pesquisa por “gato francês” no Laion 5b, conjunto com mais de 2,3 bilhões de imagens usado pelo Stable Diffusion

Divulgação/Laion

A falta de detalhes sobre a origem das imagens usadas para treinar os modelos é alvo de críticas de profissionais. Para o ilustrador de quadrinhos Jean Sinclair, é preciso haver uma regulamentação dos robôs.

“O maior problema dessas inteligências artificiais é que elas utilizam bancos de imagens sem creditar e remunerar os artistas. O nome desse tipo de ação é uso indevido de imagem”, afirmou.

Ele concorda que os robôs que criam imagens vieram para ficar, mas alega que eles deveriam ser usados a favor de profissionais, como acontece com softwares de edição.

“O problema é que sua utilização hoje é problemática, nociva e antiética em relação aos artistas, porque utiliza os nossos trabalhos sem consentimento para terem lucros a curto e médio prazo somente para os criadores desses programas”.

Como testar?

O Midjourney pode ser testado no aplicativo Discord. Para acessá-lo, visite este link, clique em “Join the Beta” e siga as instruções para acessar o servidor. Em seguida, visite um dos chats, escreva “/imagine” e a descrição da imagem, envie a mensagem e aguarde alguns segundos.

O Stable Diffusion é pode ser testado no site do DreamStudio – os dois foram criados pela Stability AI. Para criar uma imagem, basta fazer um cadastro, informar o que ela deve desenhar e clicar em “Dream”.

Criação do Stable Diffusion para o retrato de corpo inteiro de um astronauta em um planeta desconhecido com visual realista

Arquivo/Vitor Dornelles

Por fim, a versão beta do DALL-E 2 está disponível no site da OpenAI. Para usar o serviço, faça um cadastro ao clicar em “Sign up”, insira uma descrição em inglês, clique em “Generate” e aguarde até ele oferecer quatro sugestões de imagens.

Existem outros sistemas?

Sim. As três ferramentas estão entre as mais famosas, mas, hoje, existem várias que criam imagens a partir de comandos de texto. Entre elas, estão Stability AI, Imagen e Parti – nem todas estão abertas ao público.

ChatGPT: como usar o robô no dia a dia