Deepfakes vão complicar verificação de identidade no futuro, alerta Gartner

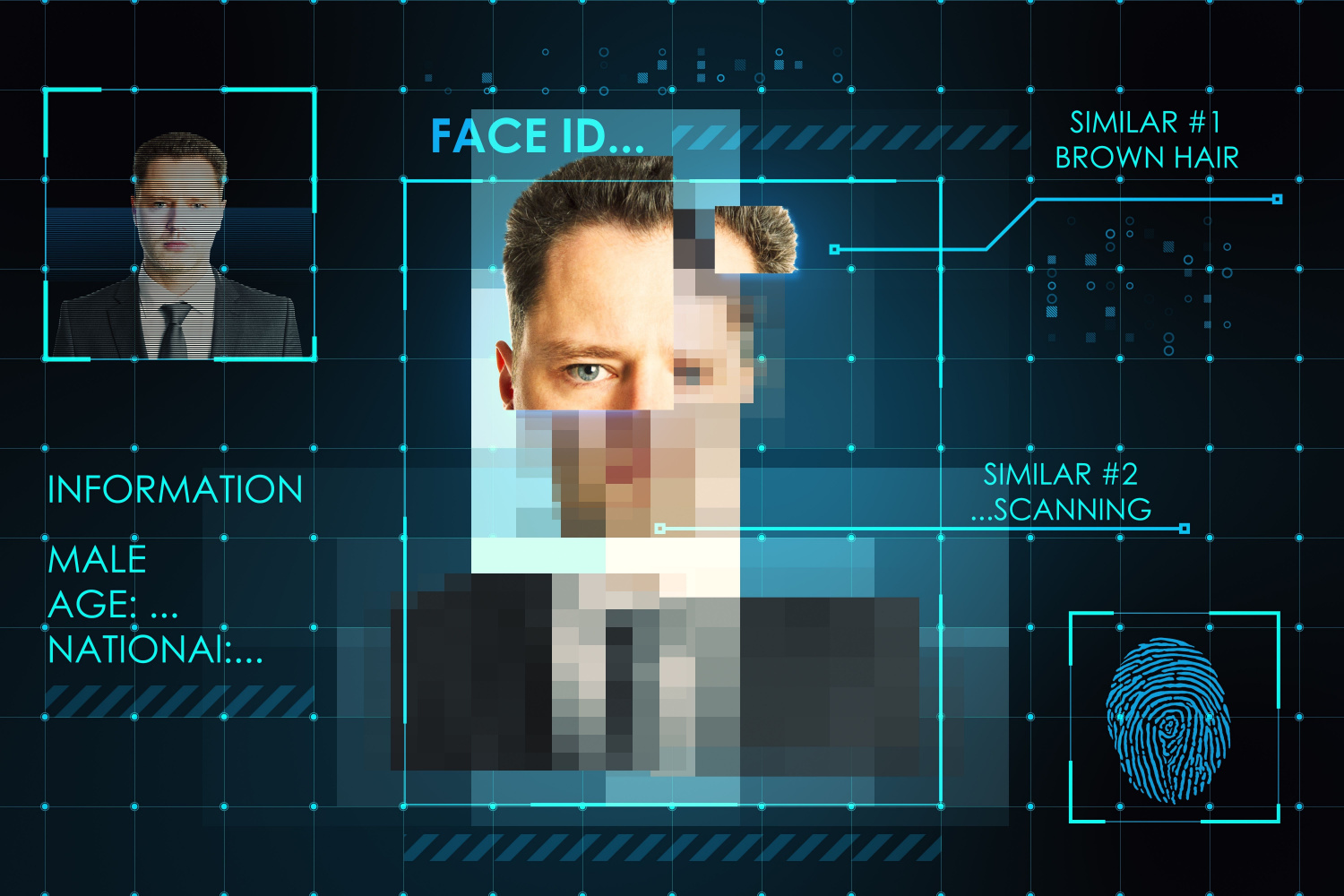

Até o ano de 2026, ataques que usam deepfakes geradas por inteligência artificial (IA) para criar biometrias faciais falsas farão com que 30% das empresas deixem de considerar soluções de verificação e autenticação como uma única resposta para o problema. O dado é do Gartner e está em um estudo divulgado recentemente.

Segundo a consultoria, os atuais processos de verificação e autenticação de identidade usando biometria facial dependem de detecção de ataques de apresentação (PAD) para avaliar a vivacidade do usuário. Mas eles não cobrem ataques de injeção digital usando deepfakes.

Leia ainda: Fortinet quer ‘subir a régua’ de canais em 2024 para crescer além do hardware

“Estas imagens geradas artificialmente de rostos de pessoas reais podem ser utilizadas por indivíduos mal-intencionados para minar a autenticação biométrica ou torná-la ineficiente”, diz Akif Khan, vice-presidente e analista do Gartner. “As empresas podem começar a questionar a confiança das soluções de verificação e autenticação de identidade, uma vez que não poderão dizer se o rosto que está sendo verificado é de uma pessoa real ou não.”

Segundo pesquisa do Gartner, ataques de apresentação são o vetor mais comum, mas ataques de injeção aumentaram 200% em 2023. Prevenir tais ataques exigirá uma combinação de PAD, detecção de ataques de injeção (IAD) e inspeção de imagens.

Dicas para CISOs

Para que as empresas se protejam contra falsificações geradas com IA, CISOs e líderes de gestão de riscos devem escolher fornecedores que possam demonstrar capacidades e um plano que vai além das normas atuais. Segundo o Gartner, eles devem comprovar que estão monitorando, classificando e quantificando novos tipos de ataques.

“As empresas devem começar a definir uma linha de base mínima de controles, trabalhando com fornecedores que investiram especificamente na atenuação das mais recentes ameaças baseadas em deepfake, utilizando a detecção de ataques de injeção em conjunto com a inspeção de imagens”, diz Khan.

Definida a estratégia, CISOs e líderes de riscos devem incluir sinais adicionais de reconhecimento, como identificação de dispositivos e a análise comportamental. O objetivo, diz a consultoria, é aumentar a detecção de eventuais ataques e riscos aos processos de verificação de identidade.

Acima de tudo, diz o Gartner, os responsáveis pela administração de identidades e acessos devem tomar medidas para mitigar riscos de ataques de deepfake orientadas por IA, selecionando tecnologias que possam provar a presença humana genuína e implementando medidas adicionais para evitar a apropriação de contas.

Siga o IT Forum no LinkedIn e fique por dentro de todas as notícias!